南科大工学院杨再跃团队在高通信效率的联邦学习领域取得新进展

2022-05-26

2022-05-26

近日,南方科技大学机械与能源工程系教授杨再跃团队在IEEE Transactions on Pattern Analysis and Machine Intelligence(T-PAMI)上发表了一篇关于高通信效率的联邦学习的研究论文,论文题为“Lazily Aggregated Quantized Gradient Innovation for Communication-Efficient Federated Learning”通过量化梯度信息和设计自适应通信机制,大幅降低了联邦学习中的通信量(一般可达50%以上)。

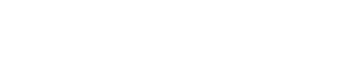

在很多实际应用中,机器学习模型需要用大量数据来训练,而这些数据一般来源于一些智能设备。若将所有数据都收集到中心服务器来进行训练,则会使得中心服务器计算负担很大,也会引起一些智能设备用户对隐私泄漏的担忧。为此,近年来联邦学习受到极大关注。如上图所示,联邦学习不要求直接收集用户的原始数据,只需要用户根据本地数据计算一些信息,上传给中心服务器用于模型训练。然而,随着智能设备数量的增加,联邦学习方法在进行模型训练的时候需要中心服务器与大量的设备通信;此外由于现在深度学习模型(学习参数数量大,常常多达10^9—10^12个参数)被广泛采用,中心服务器每次与分布式设备通信时传递的数据量很大。因而在很多实际应用中,用联邦学习进行模型训练的时候,通信负担大、延迟长,这直接导致了学习效率下降。即目前的联邦学习方法是以很高的通信量为代价来降低中心服务器的计算量,同时实现用户的隐私保护。

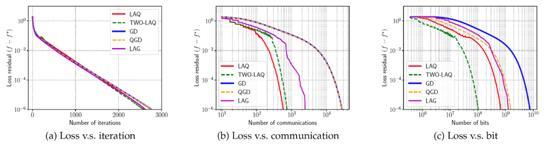

因此,该研究的主要目标是降低联邦学习中的通信量。该研究考虑基础的梯度下降算法,使用两种方法来削减通信量:1)量化梯度信息;2)设计自适应通信机制。通过量化梯度,比如使用6个比特而非64个比特来表示一个浮点数,每次通信传输的比特数可以大大减少。通过设计自适应通信机制,可以有效降低通信次数,比如若连续两次传输的信息非常相似,那么就可以考虑省下一次通信,直接使用之前的信息作为当前的一个近似。这两种方法都将给梯度引入误差,但该研究证明了通过合适的设计,训练过程的收敛性是有保证的,并且对于强凸优化问题,所提出的算法能够保证线性收敛(或称指数收敛或几何收敛),并且论文清晰地刻画了收敛速度和设计参数之间的关系。如下图所示的实验结果验证了算法的收敛性,并且与现有方法相比,所提出的方法显著降低了训练过程的总通信量(图中LAQ和TWO-LAQ为课题组提出的算法)。

图1 损失函数收敛性(a)损失函数随迭代次数的变化(b)损失函数随通信次数的变化 (c)损失函数随通信比特数的变化

本文的研究在保证模型学习效果的基础上,大大减小了联邦学习中的通信量,一般可达50%以上,从而降低服务器与设备间的通信带宽要求,也可以缩短训练耗时,具有很强的理论和工程意义。

该论文由南方科技大学、浙江大学、伦斯勒理工学院、明尼苏达大学共同完成。南方科技大学访问学生孙俊为论文第一作者,通讯作者为杨再跃,南科大为论文第一单位。该项目由国家自然科学基金、广东省国际科技合作项目、深圳市国际科技合作项目等资助。

论文链接:https://ieeexplore.ieee.org/abstract/document/9238427

最新资讯

相关新闻